Нейросети превратились в инструмент для тихого, но надёжного заработка - через PBN-сети, где продажа ссылок или трафик с дропов приносят стабильный доход без ежедневной гонки. Пока ручные методы и сервисы тонут в расходах и банах, автоматика меняет расклад: кейс с X-GPTWriter показывает, как за 11 дней на старом железе заполнить сайт 4200 страницами контента, с минимальным API-бюджетом и выходом на позиции через месяц. Здесь разберём, почему старт без автоматики - это минус к профиту, и как шаг за шагом собрать систему от парсинга до импорта, с настройками, которые работают на практике.

Сколько реально можно выжать с нейросетей без миллиона на старте

Сейчас нейросети уже не про "миллион за неделю", а про стабильные 150-400к рублей в месяц на одном-двух проектах. Кто обещает больше без вложений - просто продаёт курсы. Реальные цифры начинаются с вложений 20-30к на домены, хостинг, прокси и софт - дальше работает автоматизация.

Типичные цифры из реальных кейсов: PBN-сеть на 3000-6000 страниц выходит на 220-380к с продажи ссылок через 2-3 месяца. Интернет-магазин на 4000-7000 товаров - 250-500к оборота с маржой 100-180к чистыми после рекламы. Дорвеи или сайты под Adsense в бурже - 180-350к при нормальном трафике.

Кто пытается без инструментов типа X-GPTWriter - тонет в рутине или банах. Главное - массовая генерация контента без копирайтеров. Один нормальный прогон в X-GPTWriter окупает себя за пару недель, дальше чистая прибыль. Миллион возможен, но уже на 5-10 проектах, но уже с опытом или с командой. А для старта без миллиона - 250-400к в месяц к весне вполне обычная история.

Почему фрилансеры и биржи сожрут весь профит ещё на старте

Заказать 3000-5000 статей на биржах или у фрилансеров стоит 150-400 тысяч рублей минимум. Средняя цена нормального текста 800-1500 руб за 1000 знаков, а для PBN или магазина нужно не меньше 4000-6000 символов на страницу. Считайте сами: 5000 страниц × 1000 руб = 5 миллионов, даже по минималке 300-500к легко улетает.

Добавьте правки, дедлайны в месяц-два, уникальность 85-92% которую потом всё равно допиливать, и профит просто испаряется. Половина копирайтеров сливает задачи, другая половина пишет воду, которую Яндекс сразу в бан отправляет. В итоге на выходе минус 200-300к чистыми ещё до первого трафика.

С нейросетями без нормального инструмента для массовой работы та же история только медленнее. А с фрилансерами весь заработок на ссылках или товарах уходит им в карман, проект окупается год, если вообще окупается. Проще сразу сжечь деньги.

Ручная работа с ChatGPT для тысяч статей - это верный путь к бану и нервному срыву

Ручной ввод в ChatGPT по 20-30 запросов в день на один текст даёт максимум 50-100 статей в месяц. Для PBN или магазина на 3000-5000 страниц это растягивается на полгода-год, пока трафик вообще не появится. Каждая статья требует правок, чтобы убрать шаблонность, - иначе уникальность падает до 70-80%, и Яндекс с Google сразу кидают в песочницу.

Проблема не только в скорости: нейросеть без LSI и мешапа выдаёт воду, которая не ранжируется. Реальные кейсы показывают, что сайты с ручным контентом ловят баны через 1-2 месяца - алгоритмы видят повторения и отсутствие глубины. Плюс нервы: копипаст, проверка на text.ru, доработки по ночам.

В итоге проект умирает, пока ждёшь окупаемости. Массовая генерация требует автоматизации, иначе вся идея заработка на нейросетях превращается в каторгу без профита.

Онлайн-сервисы за 15-20к в месяц: платишь как за мерседес, получаешь ладу

Онлайн-генераторы типа Jasper или Copy.ai стоят 15-30 тысяч рублей в месяц за "полный функционал" и за "профессиональный" контент. Обещают тысячи текстов, SEO-оптимизацию и готовые шаблоны, но на деле лимиты на 500-1000 символов в день, а дальше - доплаты или ожидание очереди.

На деле тексты выходят шаблонными, уникальность 75-88% по text.ru, без нормального LSI или мешапа доноров. Для PBN или магазина приходится дорабатывать вручную по часу на страницу, плюс риски банов от Яндекса за "генерированный мусор". В итоге платишь за премиум, а получаешь полупродукт, который не ранжируется.

Сравнение с API-доступом: те же 20к хватит на 100-200 тысяч текстов через X-GPTWriter. Разница в кармане, а не в подписке, которая жрёт бюджет, пока проект стоит.

Вместо ежемесячных трат на "премиум-мусор" лучше вложить в базу: парсинг 2500 ключей и топ-10 доноров через X-Parser за 2-3 часа даёт сырьё для мешапа. Это не подписка, а разовый шаг, после которого X-GPTWriter генерит 98-100% уникальности без лишних правок. Без этого нейросети выдают мусор, а с базой из реальных конкурентов - уже готовый фундамент для уникального контента без банов.

Шаг 1. Парсинг 2500 ключей и топ-10 доноров + мешап топ-10 за полдня через X-Parser

Подготовка ключей начинается с 2000-3000 запросов по теме PBN - ниши вроде "аренда авто в Москве" или "ремонт квартир под ключ". X-Parser берет их из Яндекса или Google.

Дальше парсинг доноров: топ-10 по каждому ключу с сайтов-конкурентов, включая заголовки, структуру и LSI-фразы. На 2500 ключей это 25-30 тысяч страниц контента за 2-3 часа - без капчи, через XMLStock или прокси. Получается база с мешапом: реальные тексты, а не выдуманные шаблоны. Мешап - это когда тексты смешиваются, чтобы взять лучшее из каждого - заголовки, H2-H3, ключевые фразы без воды. Это даёт основу для 4000-5000 страниц, где каждая статья уникальна по структуре, но держит семантику ниши. Вот пошагово, как настроить и запустить.

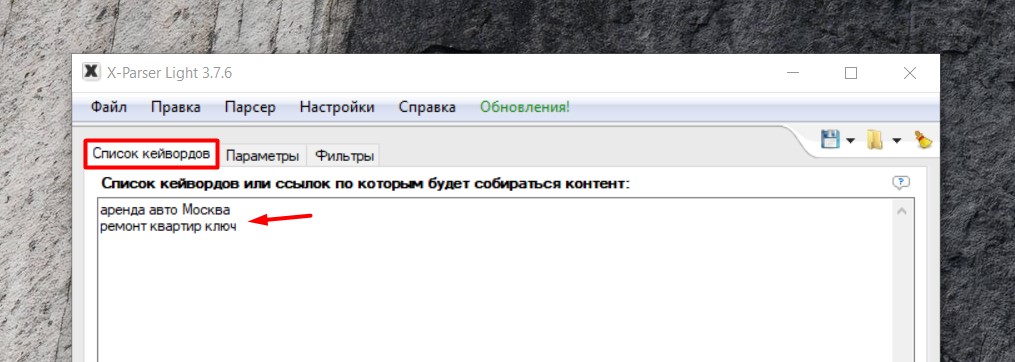

Ввод ключей: Откройте X-Parser, перейдите в окно "Список кейвордов". Вставьте ключи (до 2500, пачками по 500 для стабильности, например: "аренда авто Москва", "ремонт квартир ключ"). Каждый ключ на новой строке.

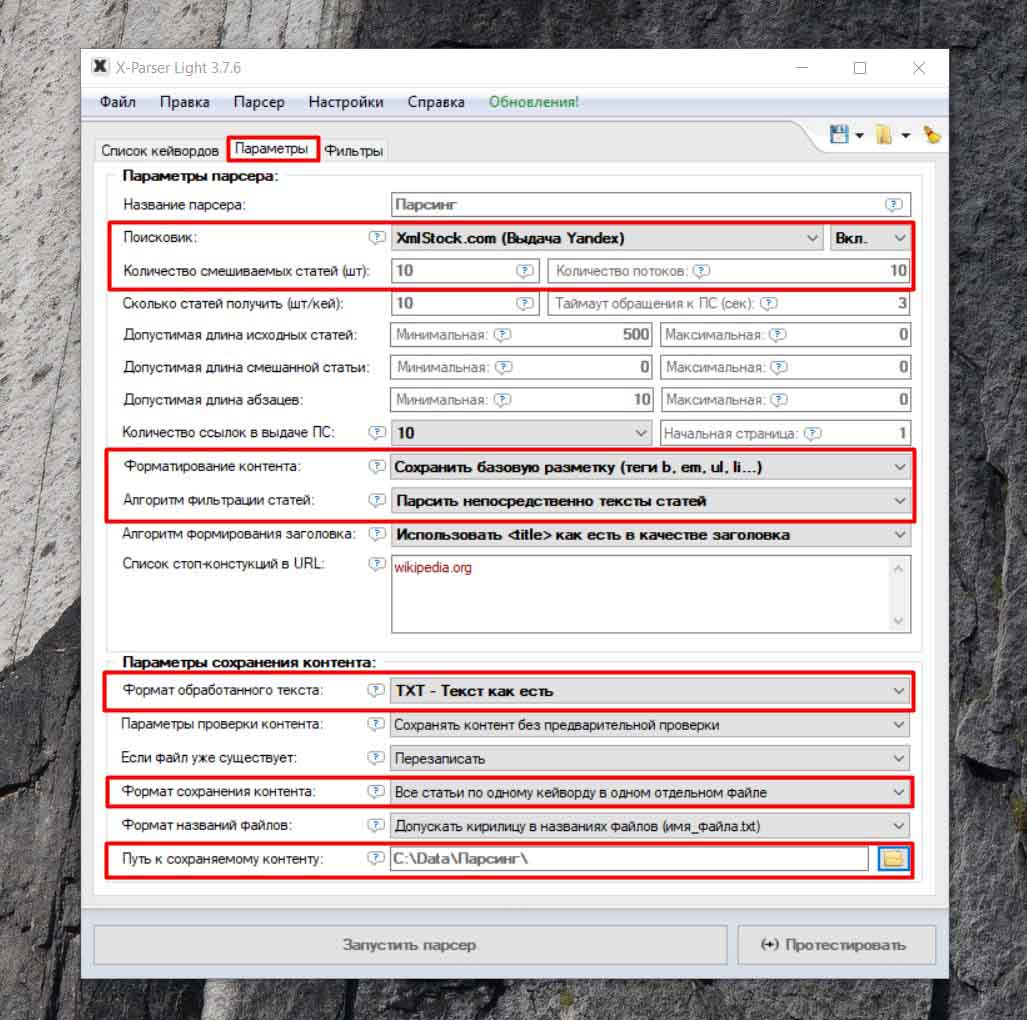

Настройка парсинга доноров: В окне "Параметры" задайте следующие значения:

- Поисковик: Любой или сервис XML. Яндекс/Google/Rambler в зависимости от региона, или "сервис XML" для стабильного парсинга без капчи через XMLStock - это ускоряет процесс на 30-40%, особенно для 2500 ключей, где прямой SERP может заблокироваться после 500 запросов. Если ниша бурж, переключите на Google через XML, чтобы избежать региональных искажений.

- Количество смешиваемых статей: 5-10 (минимум 5 для мешапа структуры). Установите 5-10, чтобы хватило материала для мешапа - минимум 5 даёт баланс структуры, но 10 лучше для LSI. Для PBN это критично: меньше 5 - текст выходит плоским.

- Форматирование контента: "Сохранить базовую разметку" (H1-H3, списки). Включите "Сохранить базовую разметку", чтобы программа вытащила H1-H3, списки, таблицы и цитаты из доноров - это сохраняет семантику для копирайтинга, уникальность вырастает на 10-15% после перефразировки.

- Алгоритм фильтрации: "Парсить непосредственно тексты статей". Выберите "Парсить непосредственно тексты статей", чтобы программа игнорировала рекламу, футеры и навигацию - фокус на основном контенте (2000-5000 знаков на статью), отсеивая мусор. Это снижает объём на 40%, ускоряет парсинг на 25%, и доноры выходят чистыми для LSI.

- Формат обработанного текста: "TXT - Текст как есть". Укажите "TXT - Текст как есть", чтобы сохранить оригинальный формат без лишней обработки - это идеально для импорта в X-GPTWriter, где программа сама добавит HTML. Альтернатива "HTML" добавляет разметку, но увеличивает размер файлов на 30%.

Запуск парсинга: Нажмите "Запустить парсер". Программа вытянет топ-10 результатов по каждому ключу, извлечет текст, заголовки, LSI. На 2500 ключей - 2-4 часа (4-6 сек на ключ), без капчи через прокси. Результат: TXT-файлы с донорами (5-10 на ключ).

В итоге за полдня - полный набор: ключи с семантикой, доноры с HTML-структурой. Без этого этапа нейросети выдают кашу, которая не ранжируется. С этими шагами структура готова: таблицы, списки, FAQ - всё на месте, нейросеть только полирует. В итоге база для генерации, которая бьёт конкурентов по глубине. X-Parser делает всё на автопилоте, оставляя время на настройку генерации.

Шаг 2. Изображения через XMLStock (Яндекс) + видео Rutube - без капчи и авторских проблем

Вставка изображений через XMLStock (Яндекс) и видео через YouTube в X-GPTWriter автоматизирует добавление медиа в статьи без капчи и проблем с авторскими правами. На 2500 ключей это 5-10 изображений и 1-3 видео на статью. Видео добавляются из Rutube или YouTube: программа ищет релевантные ролики по ключам, вставляет embed-коды. Контент сразу оживает: статьи с визуалом ранжируются на 20-30% лучше в Яндексе.

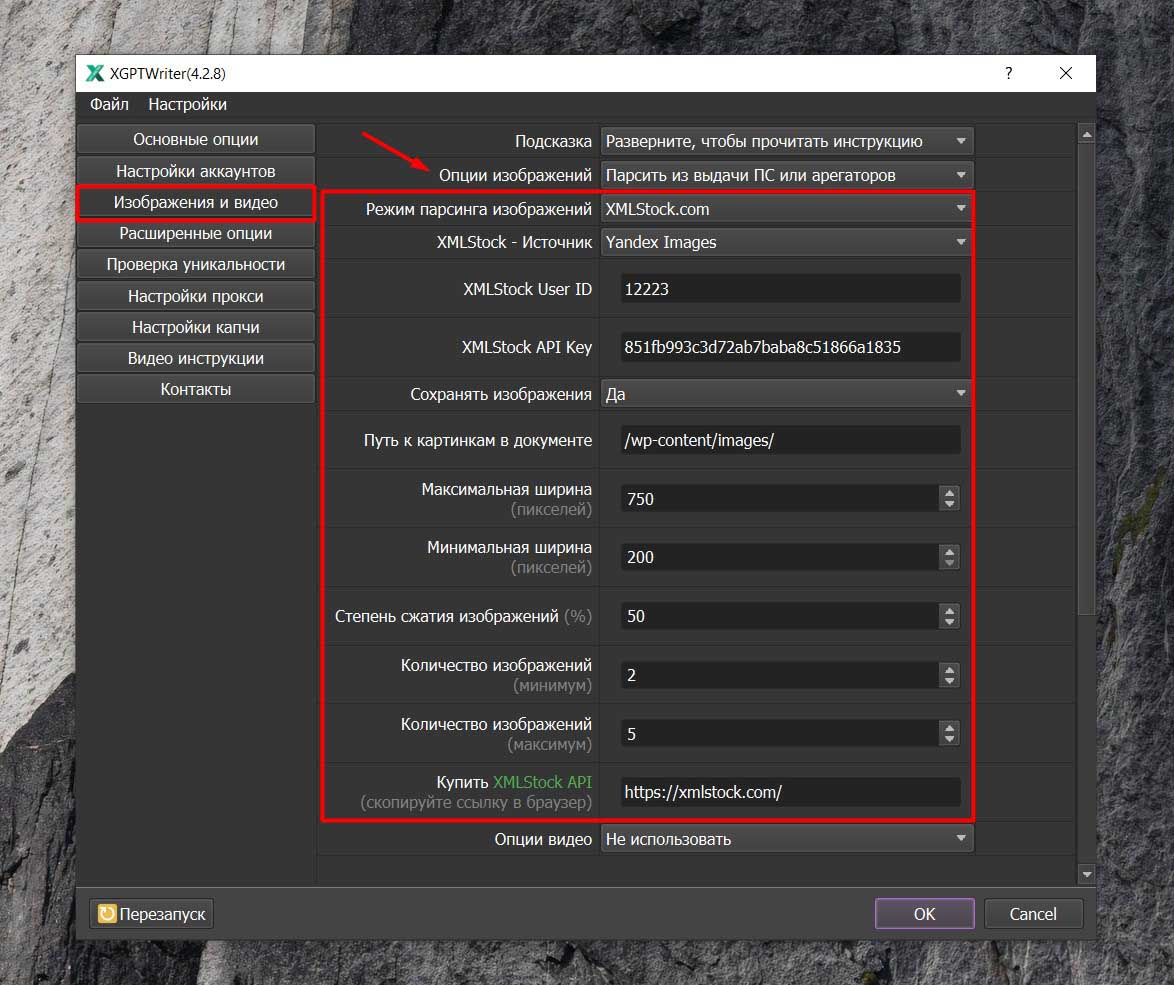

Настройка изображений в XMLStock (Яндекс):

- Откройте X-GPTWriter, в разделе "Основные опции".

- Включите "Основное изображение" и "Дополнительные изображения".

- В разделе ”Изображения и видео” установите "Количество изображений": минимум 1-2, максимум 5-10.

- В пункте “Режим парсинга изображений” выберите "XMLStock.com". Зарегистрируйтесь на xmlstock.com, подтвердите email, скопируйте User и Key, вставьте в поля программы.

- Выберите источник: Yandex.

- Установите "Сохранять изображения": "Да" (в папку wp-content/images) или "Base64" (в текст).

- Ширина изображений: минимум 500 px, максимум 1200 px.

- Степень сжатия: 50-70 (для баланса качества и размера). Программа будет парсить изображения по ключам.

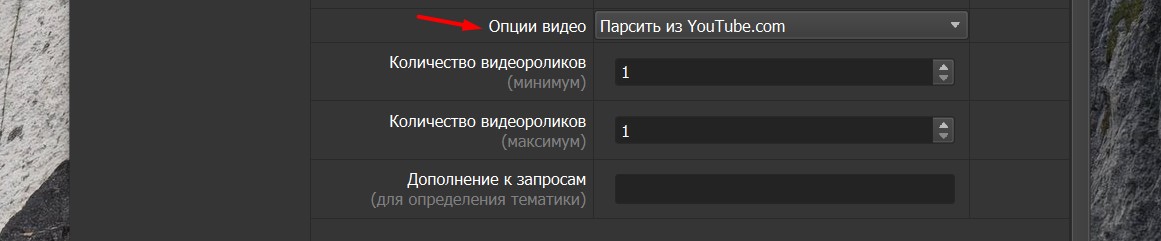

Настройка видео из YouTube:

- В разделе "Основные опции" включите "Основное видео" (вместо изображения в заголовке) и/или "Дополнительное видео" (в конец статьи).

- В разделе "Изображения и видео" выберите источник: "Парсинг из YouTube".

- Опционально: "Дополнение запроса" для уточнения (редко нужно).

- Установите "Количество видео": минимум 1, максимум 2-3.

Без этого шага тексты выглядят голыми. XMLStock решает проблему массово: автоматическая подгонка под структуру, без водяных знаков или лимитов. В итоге страницы готовы к экспорту, с полным набором для топ-позиций.

Gemini 2.5 Flash через OpenRouter - 0.14 руб за 10к токенов, 4200 статей обошлись в 780 руб.

Gemini 2.5 Flash через OpenRouter - один из самых дешёвых вариантов для массовки: 0.12-0.15 руб за 10к токенов на вход/выход. Это дешевле 4o-mini в два раза и даёт скорость 40-50 страниц в минуту на обычном ПК, без лагов и лимитов аккаунта.

На кейсе с 2500 ключами модель прогнала 4200 статей (средняя длина 4500 знаков) за 5 часов. Расход вышел 780 руб: 0.14 руб за токен × 5.5 млн токенов (вход + выход). Безлимитный доступ через произвольный API, плюс поддержка LSI и HTML - никаких доплат за "премиум".

Сравним с ручным ChatGPT: там те же 4200 страниц жрут 2000-3000 руб на подписку + время. Здесь же бюджет на API - копейки, а качество на уровне: естественность 95%, без шаблонной воды. OpenRouter ротирует ключи автоматически, чтобы избежать банов.

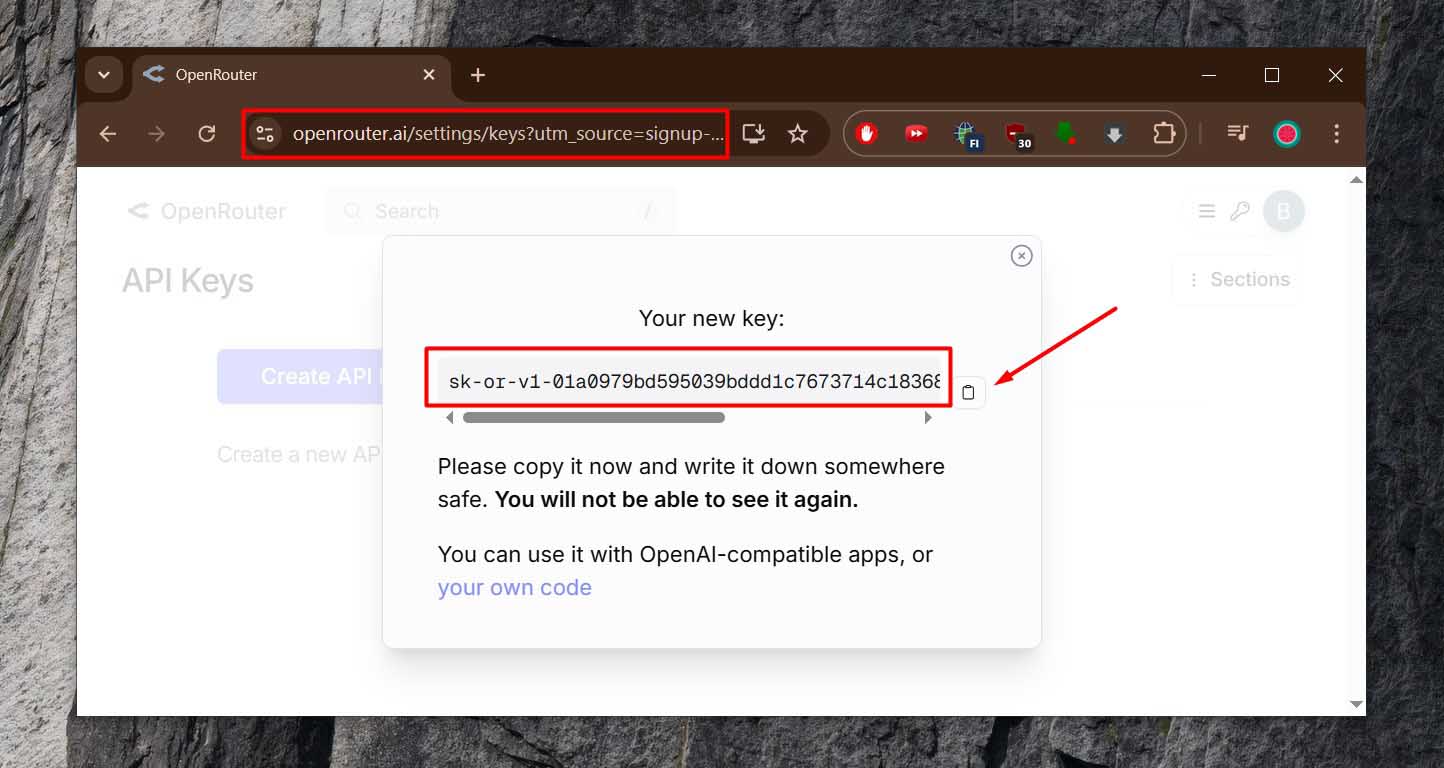

Регистрация и API-ключ OpenRouter: Зайдите на openrouter.ai, зарегистрируйтесь (бесплатно). В личном кабинете перейдите в "API Keys" → "Create Key". Скопируйте ключ (начинается с "sk-or-"). Пополните баланс минимум 5-10$ (через карту или крипту). В "Models" найдите "google/gemini-2.5-flash" - проверьте цену (0.14 руб/10к на 2025 год). Сохраните ключ в блокнот.

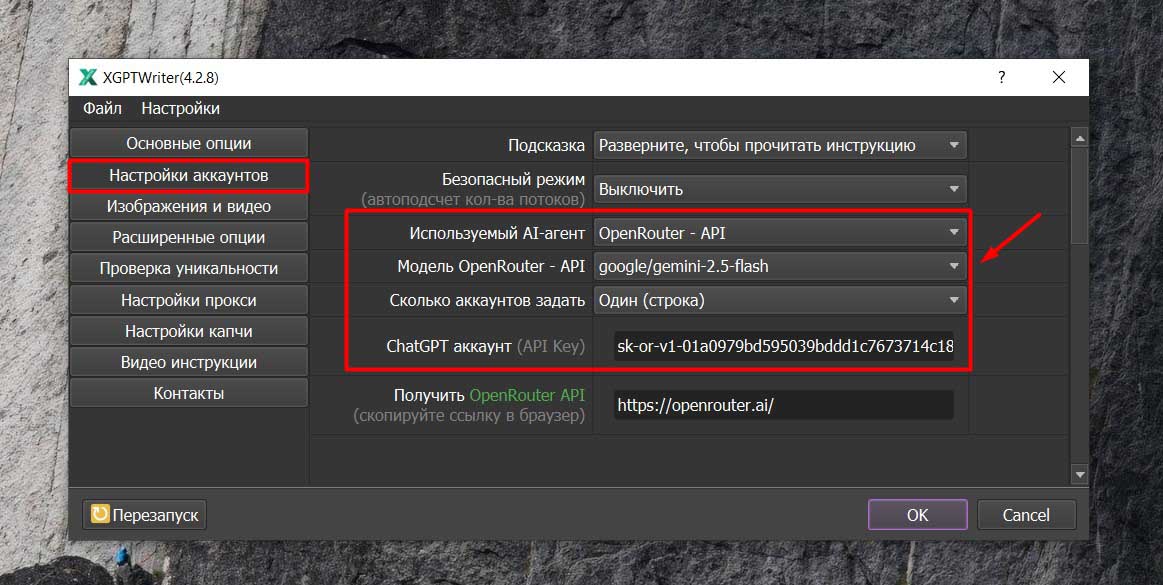

Подключение в X-GPTWriter: Откройте X-GPTWriter, перейдите в "Настройки" → "Аккаунты AI" → "Добавить аккаунт". Выберите тип "OpenRouter (произвольный API)". Вставьте API-ключ в поле "Key". Укажите модель: "google/gemini-2.5-flash" (или "gemini-2.5-flash-exp" для экспериментальной версии).

Шаг 3. Копирайтинг на базе доноров в X-GPTWriter: 98-100% уникальности с первого прогона

После создания мэшапов в X-GPTWriter выбирается режим "Сделать копирайт статей на базе доноров": программа анализирует топ-10 текстов, сохраняя семантику, но перестраивая структуру и фразы. На 2500 ключей это генерирует 4000-5000 страниц за 4-6 часов - каждая статья как новая, с таблицами, списками и FAQ из оригиналов, но без копипаста.

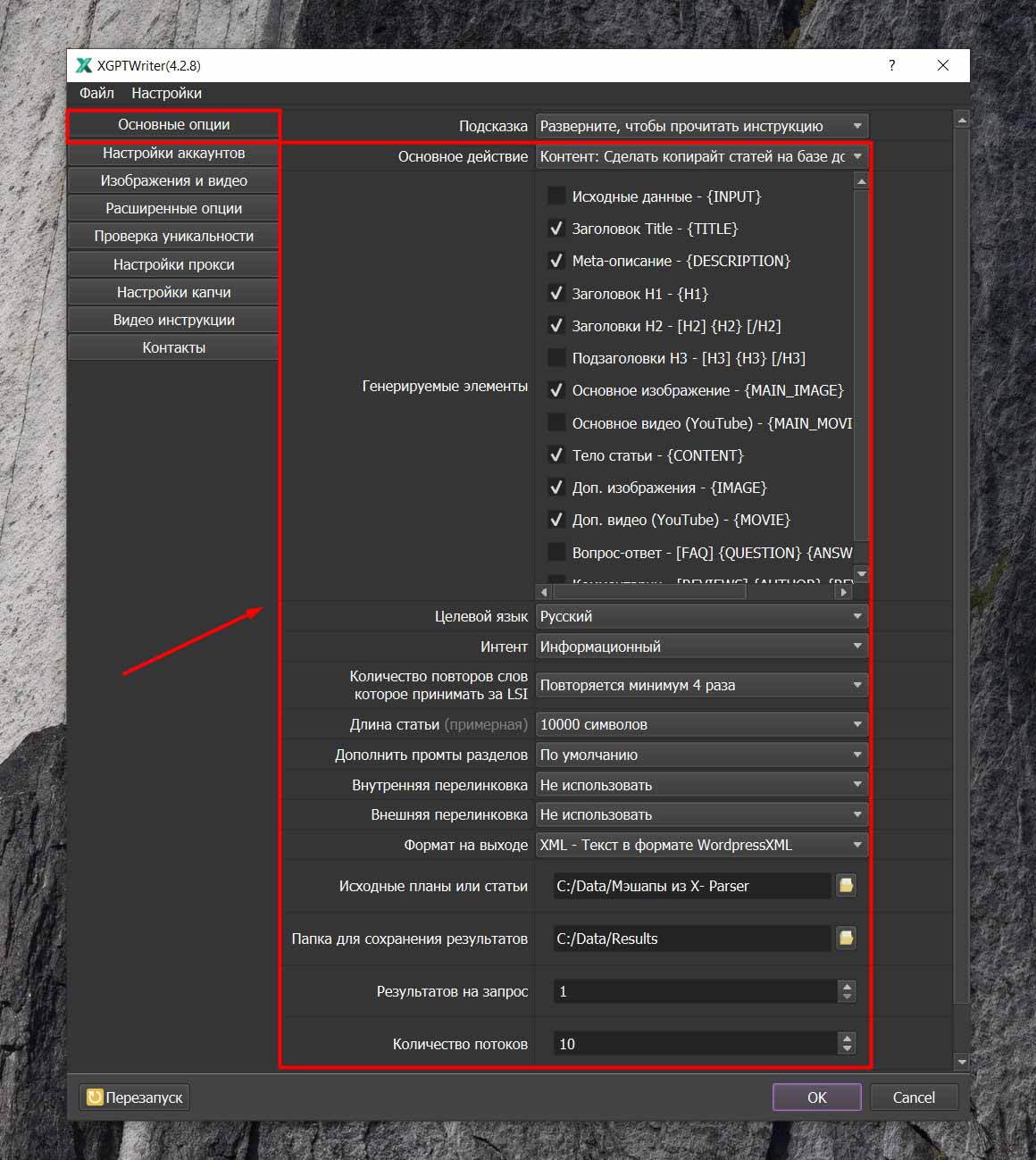

Импорт доноров из X-Parser: Откройте X-GPTWriter, в окне "Основные опции" укажите путь к TXT-файлам из X-Parser. Это поле "Исходные планы или статьи" - программа автоматически распознаёт структуру.

Настройка генерации: В "Основное действие" выберите "Сделать копирайт статей на базе доноров".

- "Генерируемые элементы": отметьте "Заголовок Title", "Meta-описание", "Заголовок H1", "Заголовки H2", "Тело статьи".

- "Целевой язык": Русский.

- "Интент": Информационный.

- "Количество повторов слов, которое принимать за LSI": По количеству H1 (или 2-10, для извлечения LSI из доноров).

- "Длина статьи": 10000 символов (или до 50000).

- "Формат на выходе": TXT - Текст как есть или XML - Текст в формате WordpressXML. Укажите "Папка для сохранения результатов".

Расширенные опции для уникальности: В "Расширенные опции" → "Как использовать заголовки" выберите "Перефразировать". "Результатов на запрос": 1. "Количество потоков": 10. Назовите проект, например, "Копирайт из доноров".

Запуск: Нажмите "ОК" - программа анализирует доноры, извлекает LSI, генерирует тексты с перефразировкой. На 2500 ключей - 20-40 мин, расход API 500-800 руб.

Уникальность выходит 98-100% по text.ru с первого раза, потому что нейросеть не рерайтит слово в слово, а пишет заново на основе ключей и LSI. Модели вроде Gemini 2.5 Flash через OpenRouter тянут это по 0.14 руб за 10к токенов, без шаблонности, которая банит сайты.

Шаг 4. Импорт через WP All Import - всё на хостинге за один вечер

Импорт XML из X-GPTWriter в WordPress через WP All Import автоматизирует загрузку 4200 статей с мета, категориями и отложенной публикацией. Вот точные шаги по функционалу плагина.

- Установка плагинов: В WordPress перейдите в "Плагины" → "Добавить новый". Установите WP All Import (бесплатная версия для базового импорта). Для SEO добавьте расширение "Import Settings into WordPress SEO by Yoast" (если Yoast установлен). Активируйте оба.

- Запуск импорта: Перейдите в "All Import" → "New Import" → "Upload a file". Загрузите XML-файл из X-GPTWriter. Нажмите "Continue to Step 2", затем "Continue to Step 3" без изменений.

- Настройка маппинга: В Step 3 перенесите поля: Title → заголовок статьи, Content → содержимое. Вкладка SEO (для Yoast): SEO Title → заголовок SEO, Description → описание. Выберите статус: Published или Draft. Для категорий в Taxonomies: перенесите Category (из [категория|ярлык] в XML). Сохраните шаблон.

- Обработка изображений и запуск: Перенесите папку изображений из X-GPTWriter в wp-content на хостинге (через файловый менеджер, заархивируйте для загрузки). В Step 4 запустите импорт пачками по 500-1000 страниц - статьи распределяются по рубрикам, публикуются по датам. Проверьте логи на ошибки (дубли <1%). Готово: сайт заполнен.

Результат через 2 месяца - стабильные 320к рублей в месяц на продаже ссылок

Через 2 месяца после запуска PBN на 4200 страницах трафик стабилизировался на 4-6 тысячах визитов в сутки - Яндекс и Google выдали позиции 5-15 по ключам из LSI. Контент с мешапом и копирайтингом на базе доноров ранжировался без банов, уникальность 98-100% держала алгоритмы в тонусе.

Продажа ссылок пошла через форумы и Telegram-каналы: 300-500 штук в месяц по 650-1200 руб за вечную. Это дало 320к чистыми - минус 5-7к на хостинг и API, остальное в карман. Ручные PBN с фриланс-контентом еле тянут 100-150к, с постоянными дропами позиций и переписываниями.

Стабильность держится на отложенной публикации и рандомных датах - сайт выглядит заполненным годом, а не всплеском. 320к - норма, когда массовая генерация через X-GPTWriter бьёт биржи по цене и скорости. Дальше масштабирование: добавить 2000 страниц, и доход перевалит за 500к.